Sessione 1

Control Task

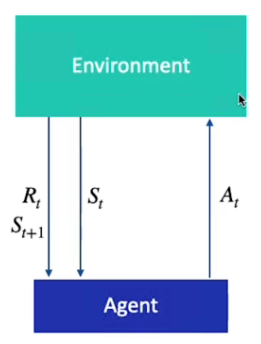

Il Task di Controllo è una sequenza di stati e di azioni, gli elementi dei task di controllo sono:

1) Stati S(t) gli stati sono, come dice la parola, sono dei momenti nel tempo che hanno un certo valore

2) Azioni, sono le azioni eseguibili nell'ambiente basate sullo stato del task ed eseguite in un determinato momento nel tempo

3) Ricompensa, è un valore che l'agente riceve dopo aver eseguito un'azione

4) Agente, l'agente è l'entita che partecipa al task che asserva lo stato ed effettua le azioni.

5) L'ambiente, è dove vengono eseguete le azioni da parte dell'agente ed otteneuta una ricompensa e una osservazione.

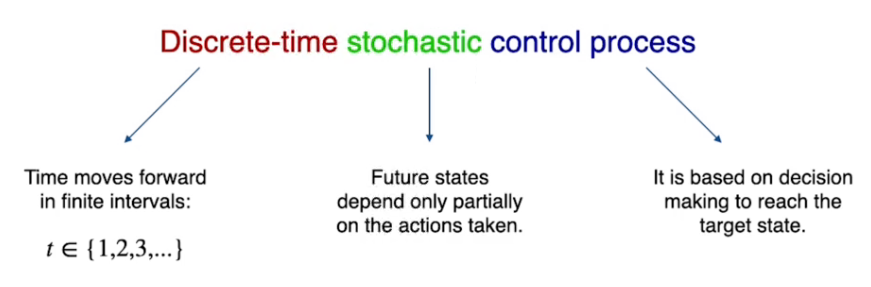

MDP

MDP sta per processo decisionale di Markov, è un template che serve per descrivere i task di controllo.

E' un controllo di processo a tempo discreto, stocastico basato su un tempo discreto.

L'MDP si basa su 4 elementi detti (S,A,R,P) ovvero:

- il set di possibili stati appartenenti al task

- il set di possibili azioni che possono essere intraprese in ciascun stato

- il set di possibili ricompense restituite a fronte di una azione intrapresa nello stato

- la probabilità di passare da uno stato all'altro eseguendo ogni possibile azione.

L'MDP ha una importante proprità, ovvero la probabilità di visitare lo stato successivo dipende esclusivamente dallo stato attuale, il processo di Markov NON ha quindi memoria del passato.

MDP si diverifica in due tipologie ovvero:

- Finito

- Infinito

- Episodico

- Continui

Nella versione versione finita le azioni, gli stati e le ricompense sono finite, mentre nella versione infinita uno o più dei tre valori sono infiniti. (un esempio di task finito è il labirinto griglia, mentre infinito può essere la guida automatica perchè il valore della velocità è infinito)

Nella versiona episofica l'episodio ha uno stato terminale mentre (come per es. l'uscita dal labirinto) nella versione continua non esiste uno stato stato terminale.

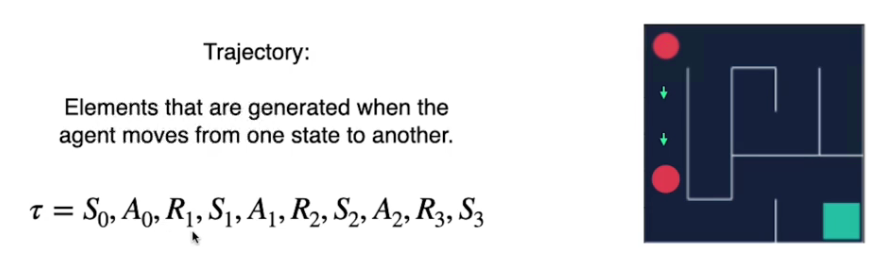

Traiettoria vs Episodio

La traiettoria è la seguenza stato, azione e ricompensa partendo da uno stato iniziale fino a giungere ad uno stato finale. La traiettoria di identifica con la lettera greca tau 𝛕

L'episodio in invece è una traiettoria che inizia da uno stato e finisce nello stato finale.

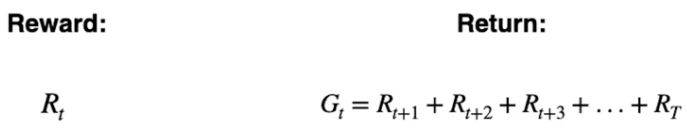

Ricompensa vs Ritorno

La ricompensa è il risultato immediato che l'azione produce.

Il ritorno è la somma delle ricompense che l'agente ottiente da un certo momento nel tempo (t) finchè lo stato è completato.

Ovvero:

L'intento è quindi quello di massimizzare il ritorno atteso.

Fattore di sconto